A、 评估

B、 训练

C、 预测

D、 输出模型

答案:ABCD

解析:解析:Estimator是谷歌为了简化和规范化机器学习编程过程而提出来的,它封装了以下几个部分:训练(training)评估(evaluation)预测(prediction)模型输出(exportforserving)其中,前三部分都是再modelⱣⱤfn函数中定义的

A、 评估

B、 训练

C、 预测

D、 输出模型

答案:ABCD

解析:解析:Estimator是谷歌为了简化和规范化机器学习编程过程而提出来的,它封装了以下几个部分:训练(training)评估(evaluation)预测(prediction)模型输出(exportforserving)其中,前三部分都是再modelⱣⱤfn函数中定义的

解析:解析:(在复杂任务中,如目标检测和语义分割等,池化层可能会导致信息丢失)

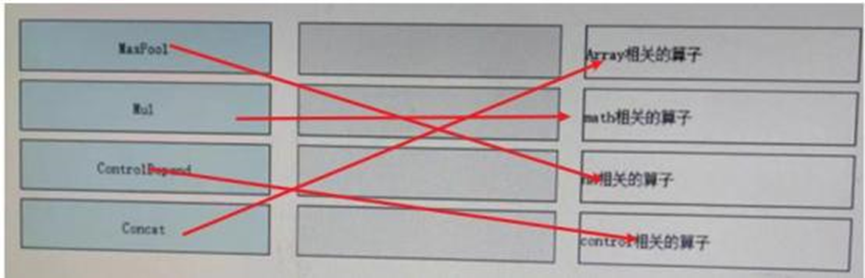

A. split

B. join

C. concat

D. unstack

A. TRUE

B. FALSE

A. 大小核智能超频

B. 内存复用.

C. 联邦学习.

D. 异构调度.

MindInsight是MindSpore提供的可视化工具,可用于完成训练可视化、性能调优、精度调优等任务。

MindInsight是MindSpore提供的可视化工具,可用于完成训练可视化、性能调优、精度调优等任务。

解析:解析:逻辑回归只能用于二分类问题,如果是多分类问题,我们通常使用Softmax函数。Softmax回归是逻辑回归的一般化,适用于K分类的问题。

A. 全局梯度下降比随机梯度下降速度更快。

B. Adam不属干梯度下降算法。

C. 随机梯度下降对噪声点敏感。

D. 使用梯度下降时,学习率应该保持一致。